Ứng dụng AI trong phát triển phần mềm đang trở thành một phần không thể thiếu trong thời điểm hiện tại. Báo cáo của DORA (Google) cho thấy 90% chuyên gia công nghệ sử dụng AI trong công việc hằng ngày, trong khi GitHub ghi nhận 41% mã nguồn toàn cầu hiện đã được tạo bởi AI, và ở các dự án Java, tỷ lệ này lên đến 61%.

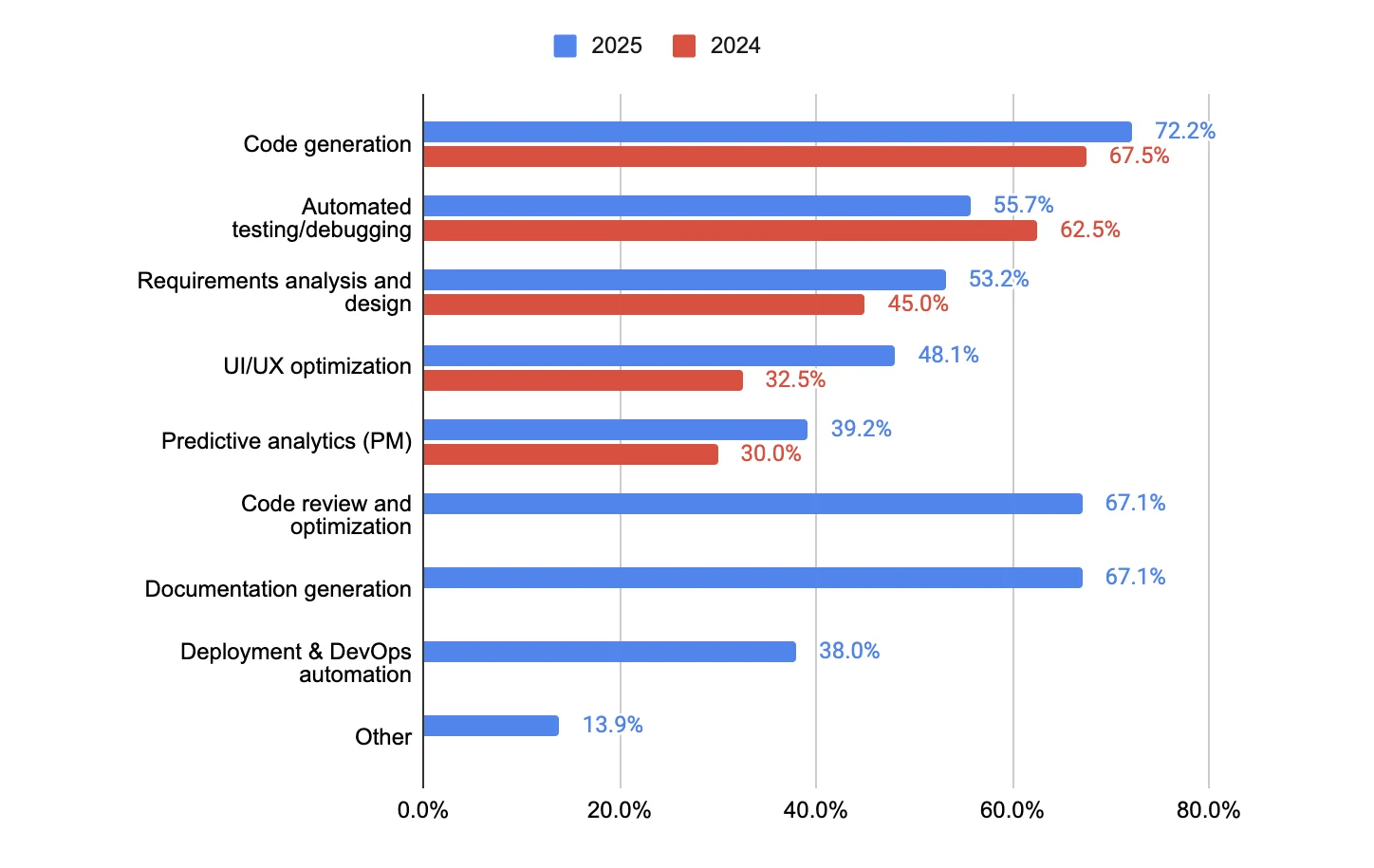

Biểu đồ Ứng dụng AI theo Tác vụ trong Phát triển Phần mềm: So sánh 2025 và 2024

Song song với sự bùng nổ về năng suất là một thực tế đáng lo ngại. Theo báo cáo của IBM, 13% các tổ chức được khảo sát đã báo cáo các vụ rò rỉ liên quan đến mô hình AI hoặc ứng dụng AI. Điều này khiến vấn đề an toàn dữ liệu trở thành rào cản lớn nhất khi doanh nghiệp muốn ứng dụng AI vào quy trình phát triển.

Trong bài viết này, CDO Miichisoft chia sẻ góc nhìn thực tế về việc ứng dụng AI trong phát triển phần mềm cho khách hàng một cách an toàn.

4 rủi ro bảo mật phổ biến nhất khi ứng dụng AI trong phát triển phần mềm

-

Rò rỉ dữ liệu và mã nguồn khi sử dụng AI công khai

Rủi ro lớn nhất và phổ biến nhất khi dùng AI trong phát triển phần mềm đến từ việc kỹ sư vô tình đưa mã nguồn, tài liệu nội bộ hoặc thông tin khách hàng vào các công cụ AI công khai. Những dữ liệu này sau đó được gửi lên máy chủ bên ngoài, có thể bị lưu lại trong log hoặc được sử dụng để huấn luyện mô hình.

Một ví dụ điển hình là vụ việc tại Samsung năm 2023: một số kỹ sư đã sao chép mã nguồn nội bộ và thông tin nhạy cảm vào ChatGPT để nhờ hỗ trợ, dẫn đến rò rỉ dữ liệu và khiến Samsung phải cấm hoàn toàn việc sử dụng các công cụ AI tạo sinh trong nội bộ. Đây là minh chứng rõ ràng về mức độ nghiêm trọng của vấn đề nếu doanh nghiệp không có quy định kiểm soát ngay từ đầu.

Nguồn: Google

-

Mã nguồn do AI tạo ra tiềm ẩn lỗ hổng bảo mật

Đây là rủi ro phổ biến nhất khi ứng dụng AI trong phát triển phần mềm khi các nghiên cứu đã chỉ ra rằng 45% mã nguồn do AI tạo ra giới thiệu các lỗ hổng bảo mật. Code do AI tạo ra thường chứa các lỗ hổng phổ biến như thiếu kiểm tra đầu vào, xử lý dữ liệu chưa đủ an toàn hoặc tuân thủ không đầy đủ các chuẩn bảo mật.

Nguyên nhân của vấn đề này là do các mô hình LLM được đào tạo trên kho lưu trữ mã nguồn mở khổng lồ, nơi mã an toàn và không an toàn cùng tồn tại. Kết quả là, AI có thể học và tái tạo các mẫu mã không an toàn như là một giải pháp hợp lệ. Điều này đặt ra yêu cầu bắt buộc: doanh nghiệp phải kiểm tra chéo và review kỹ lưỡng mọi đoạn mã AI sinh ra trước khi đưa vào hệ thống thật.

-

Nguy cơ bị “poisoning attacks” từ dữ liệu độc hại

Các mô hình AI có thể trở thành mục tiêu của các cuộc tấn công kiểu “data poisoning”, trong đó kẻ xấu đưa dữ liệu độc hại vào quá trình huấn luyện, hoặc khai thác điểm yếu của mô hình thông qua prompt. Kết quả là AI có thể sinh ra mã nguồn chứa lỗ hổng hoặc hành vi nguy hiểm mà người dùng không nhận ra ngay lập tức.

Nghiên cứu năm 2023 đã chỉ ra rằng các AI coding assistant rất dễ bị tấn công dạng này nếu doanh nghiệp không có quy trình đánh giá output và kiểm soát nguồn dữ liệu nghiêm ngặt khi ứng dụng AI trong phát triển phần mềm.

-

Mất quyền kiểm soát dữ liệu khi dữ liệu được gửi ra bên ngoài

Khi sử dụng các công cụ AI đám mây, doanh nghiệp thường không thể đảm bảo dữ liệu đã gửi đi có thể bị xóa hoàn toàn hoặc không được bên cung cấp dịch vụ sử dụng cho mục đích khác.

Đây cũng là một phần nguyên nhân khiến Samsung lo ngại và phải lập tức cấm nhân viên dùng ChatGPT. Trên thực tế, dữ liệu nội bộ một khi đã gửi lên hệ thống của bên thứ ba sẽ rất khó “thu hồi”. Với những doanh nghiệp sở hữu mã nguồn lõi, bí mật thương mại hoặc dữ liệu người dùng, rủi ro này đặc biệt nghiêm trọng.

Góc nhìn từ CDO Miichisoft: Quy trình ứng dụng AI an toàn trong thực tế

Trước bối cảnh này, anh Nguyễn Hà Tân – CDO của Miichisoft chia sẻ những quan sát thực tế và cách Miichisoft đảm bảo bảo mật dữ liệu khi ứng dụng AI trong phát triển phần mềm. Theo anh, rủi ro lớn nhất là dữ liệu nhạy cảm, đặc biệt là thông tin khách hàng, có thể bị lộ ra bên ngoài nếu không kiểm soát chặt chẽ. Để hạn chế nguy cơ này, Miichisoft triển khai nhiều biện pháp bảo mật nghiêm ngặt, với ba khía cạnh trọng tâm: nâng cao kiến thức, chuẩn hóa quy trình làm việc và đào tạo nhân viên.

Về mặt nhân sự, đào tạo là yếu tố then chốt. Nhân viên được hướng dẫn tận dụng kinh nghiệm và quy trình một cách hiệu quả, đồng thời được trang bị kỹ năng để sử dụng AI an toàn, đảm bảo mọi hoạt động đều tuân thủ chính sách bảo mật của khách hàng.

Cuối cùng, anh nhấn mạnh rằng để khai thác tối đa sức mạnh của AI, Miichisoft luôn cải tiến quy trình và phương pháp làm việc, hướng tới việc vừa đẩy nhanh tốc độ phát triển ứng dụng, vừa đảm bảo dữ liệu khách hàng luôn được bảo vệ nghiêm ngặt.

Cùng lắng nghe những chia sẻ của anh Tân về cách Miichisoft đảm bảo bảo mật dữ liệu khi dùng AI trong phát triển phần mềm!

Quy trình bảo mật khi dùng AI trong phát triển phần mềm tại Miichisoft

Để ứng dụng AI vào phát triển phần mềm một cách an toàn và có kiểm soát, Miichisoft xây dựng một quy trình bảo mật gồm 5 bước rõ ràng. Quy trình này giúp đảm bảo dữ liệu khách hàng luôn được bảo vệ, môi trường phát triển tuân thủ đúng yêu cầu bảo mật, và mọi thao tác liên quan đến AI đều nằm trong phạm vi an toàn.

Bước 1: Thống nhất chính sách bảo mật với khách hàng

Mọi dự án ứng dụng AI đều bắt đầu bằng việc xác định rõ phạm vi, quy định và mức độ cho phép từ phía khách hàng. Kỹ sư chỉ được phép dùng AI khi có sự cho phép rõ ràng từ phía khách hàng, và dữ liệu chỉ được xử lý trong phạm vi đã cam kết. Điều này đảm bảo rằng mọi thông tin nội bộ, mã nguồn hay dữ liệu nhạy cảm không bao giờ bị đưa ra bên ngoài một cách vô tình. Chính sự tuân thủ này tạo ra nền tảng để việc áp dụng AI trong phát triển phần mềm trở nên an toàn từ bước đầu.

Bước 2: Lựa chọn công cụ GenAI phù hợp và an toàn

Không phải công cụ AI nào cũng được phép sử dụng. Miichisoft ưu tiên sử dụng AI nội bộ hoặc các giải pháp GenAI đáp ứng tiêu chuẩn bảo mật, được khách hàng chấp thuận, tránh hoàn toàn việc gửi dữ liệu lên các dịch vụ AI công khai. Việc chọn đúng công cụ giúp đội ngũ vừa tận dụng được hiệu suất từ AI, vừa đảm bảo dữ liệu không gửi vào các dịch vụ công khai hoặc bên thứ ba không được kiểm soát.

Bước 3: Cấu hình môi trường phát triển an toàn

Để tránh rò rỉ dữ liệu, môi trường phát triển AI được tách biệt hoàn toàn với hệ thống xử lý dữ liệu dự án. Truy cập vào các hệ thống này được kiểm soát nghiêm ngặt và được phân cấp rõ ràng theo từng vai trò, chỉ những kỹ sư có quyền mới có thể sử dụng, đồng thời mọi hoạt động đều được giám sát. Cách thiết lập này đảm bảo dữ liệu khách hàng không bị trộn lẫn với môi trường thử nghiệm AI, đồng thời hạn chế tối đa nguy cơ rò rỉ từ các thiết bị cá nhân hay mạng công cộng.

Bước 4: Ứng dụng AI vào quy trình phát triển

AI được sử dụng để hỗ trợ tăng tốc và tự động hóa các công đoạn phù hợp như:

– Gợi ý, kiểm tra và tối ưu code

– Tự động hoá tài liệu như viết spec hoặc báo cáo kỹ thuật

– Hỗ trợ phân tích lỗi, debug nhanh hơn

Quan trọng hơn, AI không được dùng cho các tác vụ liên quan đến dữ liệu nhạy cảm, như xử lý database người dùng hoặc specification quan trọng. Điều này đảm bảo mọi quyết định quan trọng vẫn được kiểm soát bởi con người, đồng thời giảm thiểu rủi ro phát sinh từ những lỗi hoặc lỗ hổng tiềm ẩn trong output của AI.

Bước 5: Kiểm tra & đảm bảo an toàn trước khi triển khai

Trước khi đưa AI vào sử dụng chính thức trong dự án, PM và CTO sẽ kiểm tra toàn bộ quy trình để đánh giá mức độ an toàn. Miichisoft cũng tiến hành kiểm tra bảo mật định kỳ nhằm đảm bảo rằng việc dùng AI không ảnh hưởng đến dữ liệu khách hàng trong suốt vòng đời dự án. Đây là lớp bảo vệ cuối cùng giúp duy trì tính minh bạch và an toàn trong mọi hoạt động liên quan đến AI.

Miichisoft – Giải pháp AI an toàn cho doanh nghiệp

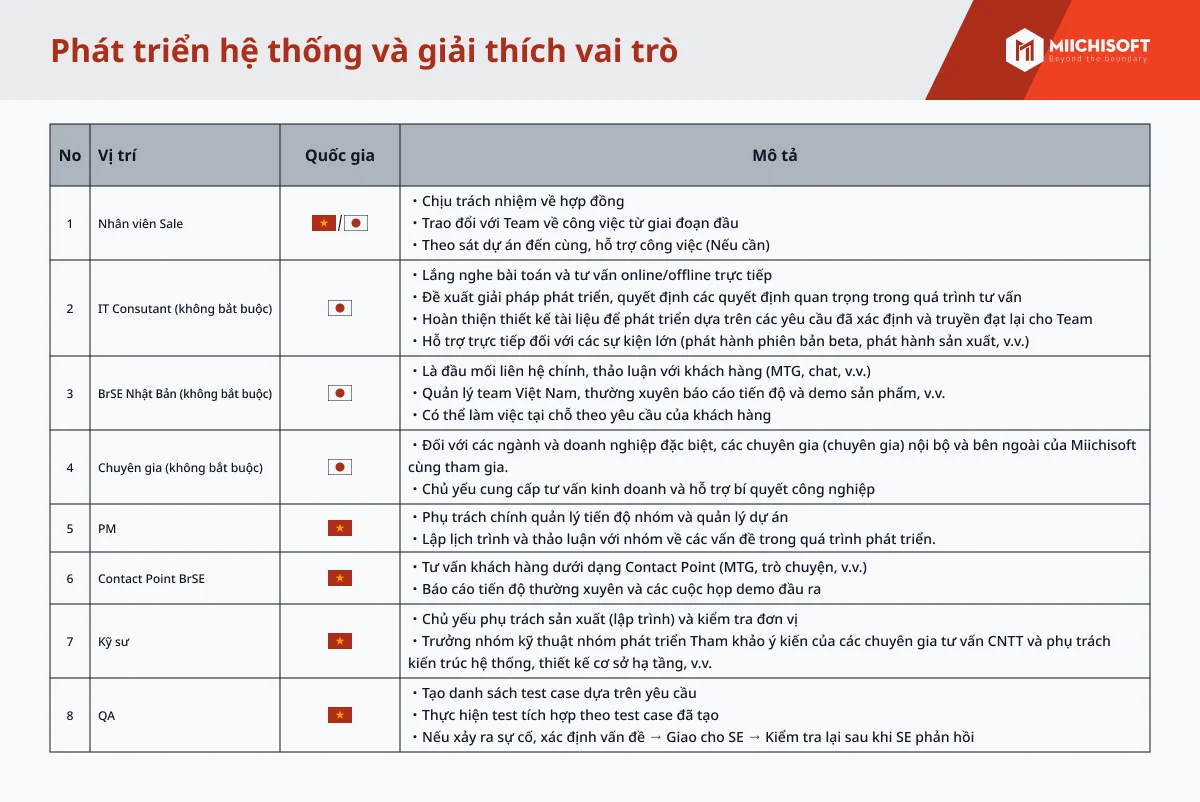

Trong bối cảnh AI ngày càng trở thành công cụ quan trọng trong phát triển phần mềm, nhiều doanh nghiệp vẫn e ngại rủi ro bảo mật. Để khai thác AI hiệu quả, doanh nghiệp cần đối tác giàu kinh nghiệm, vừa am hiểu công nghệ vừa nắm vững quy trình bảo mật.

Miichisoft sở đội ngũ thành thạo AI và tiếng Nhật, có kinh nghiệm làm việc trực tiếp với khách hàng Nhật và có văn phòng trực tiếp tại Nhật Bàn. Chúng tôi áp dụng quy trình kiểm soát bảo mật chặt chẽ và triển khai AI trong môi trường an toàn, giúp tăng tốc phát triển phần mềm, giảm lỗi con người, đồng thời đảm bảo dữ liệu khách hàng luôn được bảo vệ nghiêm ngặt.

Nếu doanh nghiệp của bạn đang loay hoay với việc ứng dụng AI vào doanh nghiệp, liên hệ ngay với Miichisoft để được tư vấn miễn phí!

FAQ

-

Dev của Miichisoft có được phép dùng ChatGPT công khai không?

Không. Mọi dữ liệu dự án quan trọng tuyệt đối không được đưa ra các công cụ AI công khai để đảm bảo an toàn thông tin khách hàng.

-

Dữ liệu có bị mô hình AI ghi log lại không?

Không. Với các mô hình triển khai local hoặc trên private cloud, dữ liệu luôn nằm trong kiểm soát của Miichisoft và khách hàng, không bị ghi log ra bên ngoài.

-

Miichisoft làm gì khi khách hàng không cho phép sử dụng AI?

Chúng tôi tuân thủ tuyệt đối yêu cầu của khách hàng, đảm bảo toàn bộ quy trình phát triển không dùng AI công khai hoặc bất kỳ công cụ nào chưa được phép.

-

Có thể triển khai AI trực tiếp trong hệ thống nội bộ của khách hàng không?

Hoàn toàn có thể. Mọi mô hình GenAI đều có thể tùy chỉnh và triển khai on-premise tại môi trường của khách hàng, đảm bảo dữ liệu không rời khỏi hệ thống.

-

Miichisoft giúp tăng hiệu quả và bảo mật như thế nào khi dùng AI?

Chúng tôi kết hợp đội ngũ thành thạo AI, quy trình kiểm soát bảo mật chặt chẽ và kinh nghiệm làm việc với khách hàng Nhật để tăng tốc phát triển phần mềm, giảm lỗi con người, đồng thời bảo vệ dữ liệu khách hàng tối đa.